Molecule attention transformer는 원자 간의 attention을 원자 간 거리와 연결 관계의 추가적인 정보를 활용하여 계산할 수 있게 한 네트워크이다. Molecule attention transformer (MAT)는 분자의 특성을 예측하는 molecule property prediction에 transformer를 사용하는 방법을 처음으로 제시한 논문이라는 의의를 가진다. 이번 글에서는 이러한 molecule attention transformer가 무엇인지에 대해 알아보겠다.

Motivation

이 논문의 motivation은 한 줄로 요약하면 transformer를 분자에도 활용할 수 있는 방법이 필요하다는 것이다. Transformer는 많은 예측이나 representation learning 문제를 성공적으로 해결해왔고, 이에 분자 구조에도 이를 활용하여 분자 특성 예측 문제를 풀고 싶은 것이다. 하지만 분자는 text 형태의 데이터와는 다르게, 원자 사이의 거리, 원자 간의 연결 관계 등 다양한 새로운 특징들을 가지고 있다. 그렇기 때문에 MAT는 이러한 분자 데이터의 특성을 transformer에 잘 녹여내는 것을 목표로 한다.

Method

이 논문의 방법은 매우 간단하다. 위에서 언급한 원자 사이의 거리, 원자 간의 연결 관계를 attention 정보에 추가적으로 넣어 주는 것이다. 이를 그림으로 표현하면 다음과 같다. 아래 그림에서 왼쪽에 있는 세 개의 박스는 각각 위에서부터 원자 간 거리, 원자 간의 연결 관계, 그리고 원자 사이의 self-attention 계산 값을 의미한다. 세 개의 정보를 모두 더한 값을 원자 간의 attention matrix, 즉 molecule self-attention으로 두고, 이를 활용하여 transformer를 통해 분자의 특성을 예측하는 것이다.

Molecule self-attention

위에서 그림으로 설명한 molecule self-attention을 식으로 표현하면 다음과 같다.

첫 번째 항은 원자 사이의 self-attention 값, 두 번째 항의의 D는 원자 간 거리, 그리고 마지막으로 세 번째 항의 A는 원자 간의 연결 관계를 의미한다. 각 항을 좀 더 구체적으로 살펴 보면, 두 번째 항의 D는 3d conformer를 활용하여 계산되고, 세 번째 항의 A는 molecular graph의 adjacency matrix를 의미한다. 이 세 개의 항들을 $\lambda$로 가중치를 다르게 주어 최종적인 molecule self-attention을 계산한다.

Pretraining

MAT는 pertaining 방법으로 masked input node를 예측하는 task에서 얻은 node level pretraining을 활용했다. 이를 통해 적은 수의 하이퍼파라미터 튜닝으로도 좋은 성능을 얻을 수 있다.

Experiments

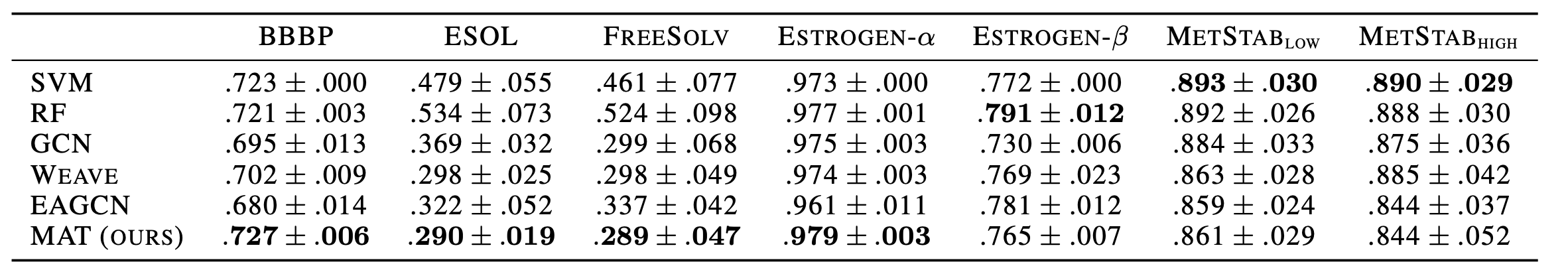

MAT의 성능은 molecule property prediction을 통해 측정되었다. 아래 표에서 리포트하는 값은 ROC AUC로 값이 높을 수록 더 성능이 좋은 것이다. 아래 표를 통해 우리는 MAT가 molecule property prediction에서 좋은 성능을 보였음을 알 수 있다.

이번 글에서는 MAT에 대하여 알아보았다. 다음 글에서는 또 다른 Transformer를 기반으로 하는 아키텍쳐인 Grover에 대해 알아보겠다. 막상 쓰면 금방 쓰는데 올해는 너무 게을렀다,,

References

Maziarka, Ł., Danel, T., Mucha, S., Rataj, K., Tabor, J., & Jastrzębski, S. (2020). Molecule attention transformer. arXiv preprint arXiv:2002.08264.

최근댓글